Die Entwicklung des Website-Monitorings: von einfachen Verfügbarkeitsprüfungen zur fortgeschrittenen Analyse der Nutzererfahrung

Im Laufe der Jahre hat sich das Website-Monitoring von einfachen Verfügbarkeitsprüfungen zu heutigen fortschrittlichen Analysemethoden weiterentwickelt. Früher mussten Administratoren und Webmaster manuelle Tests auf der Website durchführen, um festzustellen, ob sie ordnungsgemäß funktionierte. Die Umstände heute sind jedoch ganz anders. Im Gegenteil, das Website-Monitoring ist heute einfacher als je zuvor.

Da sich Technologie und Kundenerwartungen stetig weiterentwickeln, wird der Bedarf an modernen Werkzeugen nur weiter steigen. Viele Institutionen und Kunden suchen nach besseren Lösungen, die Zeit sparen und Ausfallzeiten minimieren. In diesem Blog haben wir den Entwicklungsprozess des Website-Monitorings analysiert und einige der neuesten Tools vorgestellt, mit denen sich Websites effektiv überwachen lassen.

Die Anfänge: Verfügbarkeit und grundlegende Leistungsprüfungen

Der Prozess des Website-Monitorings kam Anfang der 1990er-Jahre auf, als Unternehmen begannen, Websites einzusetzen. Zu dieser Zeit galt die Verfügbarkeit als wichtigste Anforderung. Unternehmen gingen davon aus, dass eine bestimmte Website täglich funktionsfähig sein sollte.

In dieser Ära wurden Werkzeuge wie Nagios und ein einfaches Pingdom eingeführt. Diese spielten eine entscheidende Rolle bei der Generierung von HTTP- oder ICMP-(Ping-)Anfragen in regelmäßigen Abständen oder bei auftretenden Problemen. Im Mittelpunkt stand dabei, dass im Fehlerfall eine E-Mail- oder SMS-Benachrichtigung verschickt wurde. So konnte nachvollzogen werden, warum es zum Ausfall kam und wie lange dieser andauerte.

Nachdem sich das reine Verfügbarkeitsmonitoring als unzureichend erwiesen hatte, entstanden Lasttest-Tools. Diese ermöglichten es, den täglichen Website-Verkehr zu simulieren. Durch solche Simulationen konnte das System die maximale Anzahl gleichzeitiger Nutzer abschätzen, die eine Website verarbeiten kann, bevor sie an Leistung verliert. Es war ein Schritt vom reinen Verfügbarkeits-Tracking hin zur Leistungsbewertung unter kontrollierten Bedingungen – und das sogar vor der Inbetriebnahme.

Aufkommen von synthetischem Monitoring und Real User Monitoring

Mit der Zeit entstand der Bedarf nach null Ausfallzeiten, und ältere Methoden zeigten Schwächen. Dies führte zur Entwicklung neuer, effektiverer Ansätze. Einer dieser Ansätze war das synthetische Monitoring. Diese Methode analysierte, wie Anwendungen theoretisch funktionieren sollten. Mit diesen Informationen konnten Webmaster fehlerfreie Websites gestalten und so Ausfälle minimieren.

Diese Methode, auch bekannt als Processuberwachung, verfolgt einen proaktiveren Ansatz. Statt Probleme durch Endnutzer entdecken zu lassen, simulierten synthetische Tests typische Nutzeraktionen – etwa das Einloggen, die Produktsuche oder das Abschließen eines Kaufvorgangs. Von Ladeproblemen bis hin zu geografischen Verzögerungen konnten solche Simulationen lokale Störungen und Latenzprobleme aufdecken.

Diese Methode erwies sich als äußerst effektiv – sogar in ungewöhnlichen Nachtstunden ermöglicht synthetisches Monitoring Unternehmen, ihre Leistung zu bewerten und sicherzustellen, dass kritische Prozesse reibungslos ablaufen. Für international tätige Unternehmen, die lokale Leistungsunterschiede analysieren möchten, hat sich dieser Ansatz als wertvolles Werkzeug erwiesen.

Die andere Methode – Real User Monitoring (RUM) – lieferte Einblicke in das tatsächliche Nutzerverhalten. RUM sammelt Daten von allen Website-Besuchern und bewertet Merkmale wie Ladezeit, TTFB (Time to First Byte), FCP (First Contentful Paint) und Absprungraten. Entwickler und Website-Betreiber konnten diese Informationen zur Leistungsoptimierung ihrer Seiten verwenden.

Vor allem aber markierte dieser Wandel die Weiterentwicklung des klassischen Problemlösungsansatzes. Website-Monitoring entwickelte sich vom reinen Fehlersuchen hin zur aktiven Optimierung der Nutzererfahrung. Unternehmen konnten nun kritische Fragen angehen, etwa: Wie beeinflussen Gerät, Browser oder Standort die Leistung? Hat dies Auswirkungen auf Konversionsraten oder das Nutzerverhalten?

Die UX-Revolution: nutzerzentriertes Monitoring

Nachdem sich die RUM-Methode bewährt hatte, wurde es zunehmend wichtiger zu verstehen, wie Menschen mit einer Website interagieren – nicht nur, ob sie es tun. Mehrere Methoden und Werkzeuge kamen auf, darunter Google Analytics und Hotjar. Diese Tools zeichneten Sitzungen auf, erstellten Heatmaps und verfolgten Klicks. Die daraus gewonnenen nutzerzentrierten Daten zeigten Unternehmen exakt, an welchen Stellen Besucher das Interesse verloren oder unsicher wurden.

Bereits in den frühen 2000er-Jahren wurden solche nutzerzentrierten Informationen unverzichtbar für CRO (Conversion Rate Optimization) und UX-Design. Sie beeinflussten auch die Entscheidungen zur Website-Architektur und zur Personalisierung von Inhalten. Die gewonnenen Erkenntnisse gingen weit über IT-Teams hinaus und bezogen Marketing-, Vertriebs- und Designabteilungen mit ein.

Als Nächstes integrierte Google im Jahr 2021 Core Web Vitals offiziell als Ranking-Faktor. Diese Metriken – darunter Largest Contentful Paint (LCP), First Input Delay (FID) und Cumulative Layout Shift (CLS) – dienten der Messung und Quantifizierung der tatsächlichen Nutzererfahrung. Websites, die diese Kriterien nicht erfüllten, riskierten eine schlechtere Sichtbarkeit in Suchmaschinen. Monitoring-Systeme entwickelten sich rasch weiter, um diese Kennzahlen zu erfassen. Leistung bedeutete nun nicht nur Kundenzufriedenheit, sondern auch den Erhalt von organischem Suchverkehr.

Modernes Monitoring: KI, maschinelles Lernen und prädiktive Analytik

Seit etwa 2015 richten nahezu alle Unternehmen ihre Aufmerksamkeit auf Websites. Die meisten Unternehmen betrachteten ihre Website als zentrale Schnittstelle zum Kunden – und daher war maximale Verfügbarkeit unerlässlich. Gleichzeitig wuchs das zu überwachende Datenvolumen enorm, wodurch herkömmliche Methoden überholt wurden. Moderne Systeme begannen, künstliche Intelligenz und maschinelles Lernen einzusetzen, um diese Daten zu analysieren und nützliche Erkenntnisse zu gewinnen. Statt auf Probleme zu reagieren, konnten Unternehmen nun vorausschauend agieren.

Später wurden KI-Tools eingeführt, die Verkehrsveränderungen erkannten, Serverbelastungen prognostizierten oder UX-Anpassungen basierend auf dem Nutzerverhalten vorschlugen. Diese Werkzeuge vereinfachten den Monitoring-Prozess erheblich und automatisierten die Ursachenanalyse – wodurch die durchschnittliche Wiederherstellungszeit (MTTR) bei Ausfällen stark verkürzt wurde.

Integration von Geschäfts- und Monitoring-Kennzahlen

Die heute fortschrittlichsten Monitoring-Systeme kombinieren technische Messwerte mit unternehmensbezogenen KPIs (Key Performance Indicators). Diese Integration hilft Unternehmen zu erkennen, wie Website-Performance Einnahmen und Kundenzufriedenheit beeinflusst.

Beispielsweise: Wie stark sinkt die Konversionsrate, wenn eine Seite eine Sekunde länger lädt? Welche Nutzergruppen sind am stärksten von Leistungsproblemen betroffen? Solche Erkenntnisse ermöglichen eine bessere Abstimmung zwischen Geschäftsstrategie und IT.

Die Zukunft: was bevorsteht

Das Website-Monitoring steht vor einem weiteren großen Entwicklungsschritt, da sich digitale Interaktionen weiterentwickeln. Künftige Entwicklungen deuten auf einen Wandel hin zu noch stärker verteilten, intelligenteren und datenschutzfreundlicheren Systemen hin. Im Folgenden finden Sie eine genauere Betrachtung dessen, was die nächste Generation des Monitorings erfordert – und welche Werkzeuge bereits den Weg ebnen.

1. Überwachung im Zeitalter von Edge Computing und IoT

Traditionelle zentrale Monitoring-Systeme sind dem schnellen Wachstum von Edge Computing und dem Internet der Dinge (IoT) nicht mehr gewachsen. Um Latenzen zu reduzieren und die Leistung zu steigern, setzen Unternehmen zunehmend auf Anwendungen und Dienste nahe am Nutzer – am „Rand“ des Netzwerks. Diese verteilte Architektur erfordert Monitoring-Lösungen, die in der Lage sind, in Echtzeit die Leistung von Millionen Geräten, Sensoren und Microservices gleichzeitig zu überwachen.

In Bereichen wie Smart-City-Infrastruktur, autonomem Fahren und Telemedizin zählt jede Millisekunde. Monitoring-Systeme müssen Daten von Edge-Knoten erfassen, Engpässe erkennen und schnell Gegenmaßnahmen einleiten.

2. Analytik und Datenschutz-orientiertes Monitoring

Website-Monitoring muss sich wandeln, um die Privatsphäre der Nutzer zu respektieren und dennoch wertvolle Informationen zu liefern – vor allem unter Regularien wie der Datenschutz-Grundverordnung (DSGVO) oder dem California Consumer Privacy Act (CCPA).

Zukunftsfähige Monitoring-Systeme müssen so konzipiert sein, dass sie nur die notwendigsten Informationen sicher, anonym und mit Nutzerzustimmung erfassen und verarbeiten. Dieser Wandel treibt die Branche zu datenschutzfreundlichen Analysetechnologien und weg von invasiven Drittanbieter-Cookies.

3. Aufkommen integrierter Experience-Plattformen

Die Grenzen zwischen Monitoring, Experimentieren und Personalisieren verschwimmen zunehmend. Unternehmen wünschen sich keine separaten Systeme mehr für Leistungsüberwachung, A/B-Tests und Benutzererfahrung. Stattdessen entstehen integrierte Plattformen, die all diese Funktionen intelligent in einem einzigen Ökosystem vereinen.

Diese integrierten Experience-Plattformen ermöglichen es Teams, UX-Anpassungen zu testen, deren Auswirkungen in Echtzeit zu bewerten und Nutzererfahrungen dynamisch anhand von Verhaltens- und Leistungsdaten zu optimieren. Ziel ist eine agile, datengetriebene digitale Umgebung, in der Kundenzufriedenheit und Performance-Optimierung Hand in Hand gehen.

Fazit

Das Website-Monitoring hat sich drastisch verändert – von einfachen Verfügbarkeitstests hin zu umfassenden Systemen, die alle Aspekte der Nutzererfahrung, Leistung und geschäftlichen Auswirkungen bewerten. In der heutigen schnelllebigen digitalen Welt ist das Verständnis des Nutzerverhaltens in Echtzeit unerlässlich. Die nächste Stufe dieser Entwicklung konzentriert sich auf prädiktive Einblicke, Monitoring für Edge und IoT, datenschutzorientierte Analytik und integrierte Plattformen, die es Unternehmen ermöglichen, schnell und intelligent zu handeln.

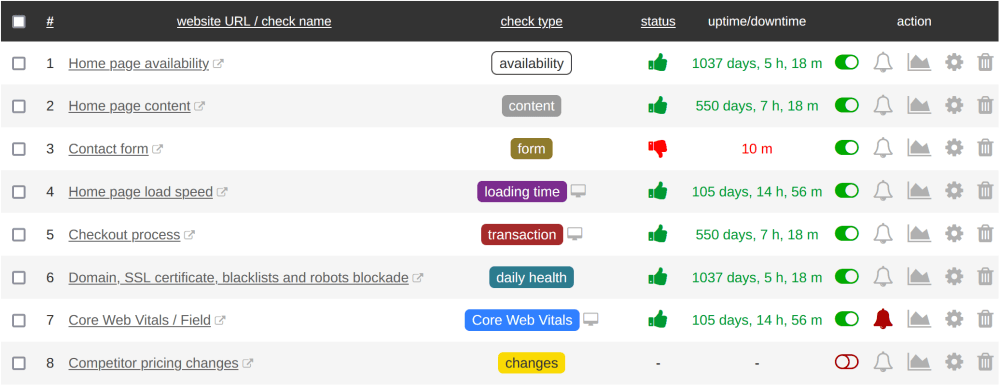

Steigende Nutzererwartungen und technologischer Fortschritt erfordern die richtigen Werkzeuge. Genau hier kommt Super Monitoring ins Spiel. Entwickelt für die digitalen Anforderungen von heute, bietet Super Monitoring zuverlässige Verfügbarkeitsprüfungen, umfassende Leistungskennzahlen und übersichtliche Berichte, die bei der Analyse und Optimierung der Nutzerreise helfen. Ob Sie eine einzelne Website oder ein ganzes digitales Portfolio betreiben – Super Monitoring liefert die nötige Transparenz und Kontrolle, um fehlerfreie und hochwertige Erlebnisse sicherzustellen.

Über den Autor

Robert Koch – erfahrener SaaS-Anwendungsdesigner und Berater für Geschäftsoptimierung durch Automatisierung. Ein begeisterter Hobbybrauer und Käsehersteller in seiner Freizeit.